感觉现在分析测序数据的话,在R中一次性读取多个文件的功能还是挺需要用到的

决定总结一下下

总不能写n行read.csv…balabala…去读取,那太麻烦了

于是决定使用批量读数据

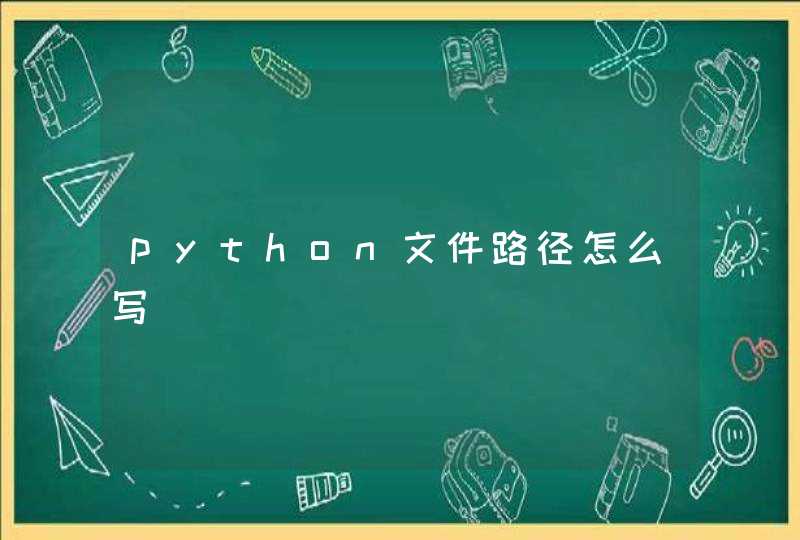

首先我们要获取这个文件夹里所有的文件名字以便读取

接下来我们需要构建读文件的路径

ps: 在做这种批量操作时还是有必要先花时间测试一个样本是否能够成功,然后再去做批量的循环,这样也能方便自己找bug

因此我们先试着读取一个文件

这里因为例子中的文件格式比较特殊,所以使用的读取函数是read.delim,如果是.csv或.txt等格式,也可以替换成read.csv, read.table等函数。

好了测试通过,接下来开始批量读文件

需要注意的是,合并文件的时候,需要注意你是要取所有文件中行名的交集还是并集,或者最后你是否有一个统一的行名来规整所有文件。(当然如果你确定每个文件的行名都是相同的,就可以直接cbind),我遇到过需要取交集的情况,可以写一个循环对每个文件的行名做交集,用最终的交集文件去match出所有你要的行然后合并。

但是这个例子中,有的文件的行名是1-4000,有的是5000-8000,存在非常大的差异,而需求是最后整合成一个行名为0-8000的矩阵,因此我先建立一个0-8000的列作为行名,把每个文件和这列进行一个match操作,然后未match到的填充为0。

其实没有很难的部分,主要是需要读取文件夹中的所有文件名,然后循环读取就行了。

使用R语言的时候,如果是少量数据,不妨使用c()或其他函数进行创建;但是对于大量数据,最好还是先通过其他更方便的软件创建数据文件,然后使用R读入这个文件。.csv是非常好的数据文件格式,跨平台支持非常好。我在Excel或者SPSS中创建的数据,只要存为csv格式,就可以使用几乎任何数据处理软件对这些数据进行处理了。使用通用格式在多人合作、不同版本兼容等常见行为中,优势十分明显。另外,之所以使用不同的数据处理软件,第一,可以取长补短。比如有些工作SPSS很复杂的,可以用R语言几行命令搞定。第二,可以进行软件间处理结果对照,发现问题。

R语言中读取外部文件的最基本函数是read.table(),还有用来读csv的read.csv(), .csv是非常好的数据文件格式,跨平台支持非常好。。

输入help(read.table)命令,就看到了关于数据输入函数的说明。

杀杀

记录一些R语言读入数据的方法还有可能遇到的问题~

读入数据时,需要先了解数据文件的类型(也就是看后缀)。一般就能够知道数据的类型和分隔符等信息。

另外,如果能够用excel预览一下数据的话,可以先看看数据是否有行列名。有些数据会有两列的行名,如基因名-基因id-表达值······,特殊的数据需要额外的处理。

还需要注意一下matrix和data.frame的数据结构,matrix中只能有一种数据类型,这意味着如果在读入数据时不进行合适的处理,R会将数值强行读成字符型,造成读数据的错误。

当用excel存储过之后,再用R处理时,会提示你行名重复,其实根本没有重复。因此建议不要用excel保存这种数据,一定要编辑可以使用notepad++或者ultra edit等软件。

-----正题分割线-----

read.xx的函数是R的内置函数,可以直接读取,并且设置一些参数

这些函数读取后都默认为data.frame,如果需要矩阵请使用as.matrix转换。

一定要赋值,不然R语言会把大大的矩阵print出来。

如果是没怎么见过的类型:

这个函数会自动识别你的分隔符,并且把第一行设为列名,但是没办法指定行名,需要读入以后自己设置

跟read.delim类似,可以读各种类型的文件以及非常大的文件:

读取后默认是一种data.table的数据类型,需要通过as.matrix/as.data.frame转换后使用。

像perl语言一样,逐行读取数据具有很大的优势

(万一文件超多行对吧)对于那种几个G的文件,全部读进来可能会导致你的电脑死机,所以我们可以先读几百行进来看看,或者分批读取,这样不会占用电脑太大内存,读取方法和上文的一次性读入有所不同-随便找个文件举例:

接下来继续读入数据,比如说我现在想读4行,因为文件是txt类型,所以分隔设为\t

第一种:把excel中所有sheet的表格读入为data.frame,并分别命名为每个sheet的名称

---请忽略硬核打码

第二种:把excel中所有sheet的表格读入为矩阵,并放进一个list中

R语言批量读文件

批量读excel的xlsx文件原理是和读其它文件一样的。

学到了新的会持续更新哟~